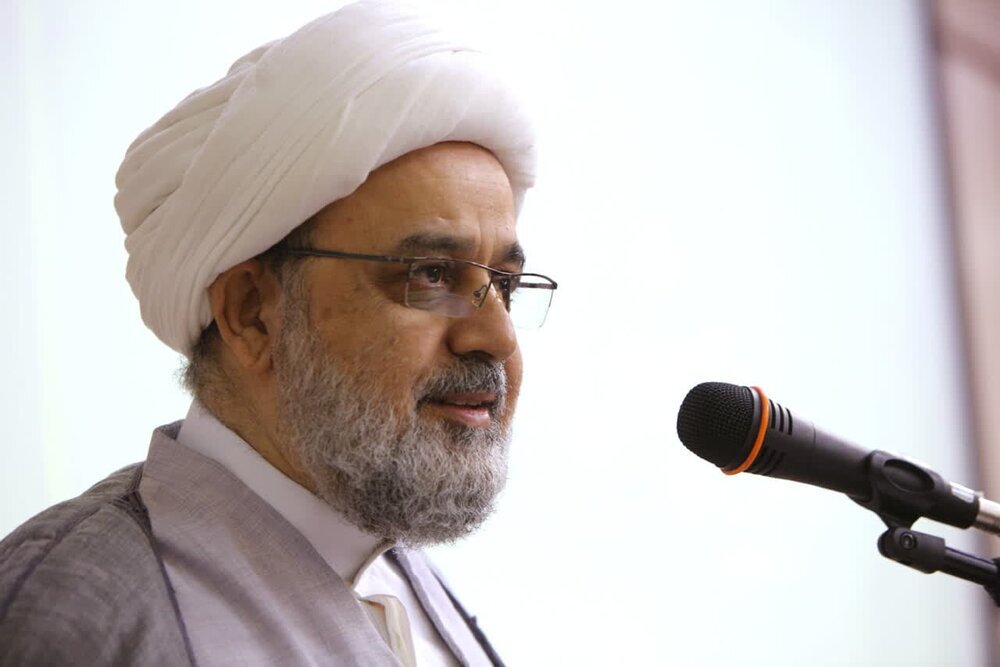

Según informó la Agencia de Noticias Hawzah, Hujjat al-Islam wal-Muslimin Hamid Shahriari, quien viajó a Catar para participar en la 26ª sesión de la Asamblea de Jurisprudencia Islámica, destacó en sus observaciones sobre las ponencias relativas a las normas y ética de la inteligencia artificial:

"El análisis de los riesgos de la IA requiere un marco lógico y estructural que aborde dimensiones técnicas, éticas, sociales, económicas y doctrinales. Por ello, propongo clasificar estos riesgos en cinco niveles: jurídico-jurisprudencial, de seguridad-política, técnico-sistémico, económico y sociocultural".

Advirtió además: "Mencionar los riesgos no basta; debemos profundizar en las amenazas existenciales y filosóficas, particularmente desde una perspectiva futurista, respaldándolas con evidencias concretas. Entre estos peligros destacan los escenarios de superinteligencia, la pérdida de control sobre sistemas autónomos y la delegación de decisiones cruciales a entidades irresponsables".

Condena al uso militar por Israel

Shahriari denunció: "Debemos ser más sensibles ante los usos actuales de esta tecnología. El arma inteligente empleada en el asesinato de los mártires Yahya Sinwar e Ismail Haniyeh debe ser investigada en esta conferencia, y las acciones del régimen sionista, condenadas. Este régimen ilegítimo posee armas nucleares, inteligentes y químicas, y corresponde a los foros jurisprudenciales esclarecer su prohibición. Estas aplicaciones comprometen gravemente la seguridad global, socavan la paz justa y violan la dignidad humana".

Marco de referencia internacional

El Secretario General subrayó la importancia de recurrir a fuentes internacionales como:

El estándar ético de la IEEE sobre IA (2019).

El informe de la UNESCO sobre ética en IA (2021), citado también por el Dr. Yasser Ajil al-Nashmi.

La legislación de la Unión Europea en IA.

Estos documentos, dijo, proporcionan marcos precisos para evaluar riesgos.

Enfoque analítico vs. discursos alarmistas

En sus conclusiones, Shahriari instó a adoptar "un enfoque analítico y basado en problemas, no meramente retórico. Expresiones como 'la IA es un instrumento para el engaño y la matanza' tienen valor de advertencia, pero no convencen a audiencias académicas o internacionales. Se requiere un examen metodológico de mecanismos técnicos —redes neuronales, aprendizaje automático, macrodatos— que preserve la dignidad humana y evite la mecanización de la sociedad".

Su comentario